[Ébauche] Les principes de la mécanique quantique – les relations d’indétermination d’Heisenberg

Cet article sera pour l’instant une ébauche que j’essaierai d’étoffer plus tard . Il m’est cependant nécessaire de présenter ce concept aussi tôt que possible afin de le relier à d’autres phénomènes, comme les fluctuations quantiques du vide.

La mécanique quantique est l’étude de l’état des systèmes physiques à des échelles très petites (typiquement à l’échelle des atomes, c’est-à-dire le milliardième de mètre, ou nanomètre). À ces échelles, en effet, les lois qui régissent la matière ne sont plus les mêmes que nos lois macroscopiques, dites « classiques ». Elles sont basées sur des principes différents, et je vais donc en présenter ici un : le principe d’incertitude d’Heisenberg, pour lequel je préfère parler des relations d’indétermination d’Heisenberg. Le principe est en effet mal nommé, car il semble suggérer que l’expérimentateur a mal fait son travail lorsqu’il a procédé à ses mesures, alors qu’il n’en est rien. Il s’agit d’une propriété des systèmes nanoscopiques, donc indépendante de la qualité des mesures effectuées !

Bref, partons du monde classique. Si je vous montre la photo d’une bille, vous serez capable de me dire où cette bille se situe précisément. Si je vous montre une vidéo de cette bille en train de se déplacer, vous pourrez me donner sa vitesse. Et si je vous dis que la photo est extraite de la vidéo, vous pourrez mettre en relation ces deux informations, position et vitesse, et vous pourrez même donner la trajectoire passée et future de la bille.

Hé bien, si la bille n’est plus une bille, mais une petite particule, vous ne pourrez pas. Tout est flou. Votre appareil photo peut avoir le meilleur focus, votre caméra la meilleure des résolutions, ça ne marchera pas. En fait, plus vous parviendrez à caractériser l’un (comme la position), moins vous connaîtrez l’autre (la vitesse, et vice-versa). Et ce, parce que cette particule, que vous imaginez comme une petite bille qui se déplace, n’est pas un tel objet. Donc sa nature n’a pas à obéir à ce dont vous avez l’habitude au quotidien.

Le principe s’écrit mathématiquement ainsi,

.

est l’indétermination dans la position de la particule,

est celle de la quantité de mouvement (le produit de la masse par la vitesse).

est la constante de Planck, un nombre ridiculement petit. C’est pour cette raison que ce principe ne se manifeste qu’aux très petites échelles : comparée à toutes les quantités physiques impliquées dans un système physique « classique » comme nous en avons l’habitude, la constante de Planck peut être considérée comme nulle. Dans ce cas précis, il n’y a plus de limite physique intrinsèque à la précision, et nous pourrions atteindre la précision que l’on veut à la fois sur la position et sur la vitesse, avec des instruments toujours plus performants.

Ah, mais… nous ne vivons pas dans ce monde-là !

Français, savez-vous comment fonctionne une centrale nucléaire ?

J’adore Youtube pour sa faculté à apporter du contenu intéressant à l’utilisateur qui s’y balade, même lorsqu’il ne recherche rien en particulier. Ce ne sera probablement pas la dernière fois que je renvoie un lien vers une vidéo, puisque je suis un petit nombre de chaînes Youtube de vulgarisation de qualité, à mon humble opinion. Pour cet article, c’est cependant la diffusion d’un débat sur le nucléaire qui a retenu mon attention (disponible ici). Je trouve le débat particulièrement intéressant, puisqu’on peut y entendre par exemple d’un avis unanime que les discussions politiques sur les énergies se perdent dans des tabous, en ce qui concerne le nucléaire. Le passage qui m’a donné envie d’écrire cet article est le suivant (à 6min45) :

« Jean-Marc Jancovici – Une des choses que l’on arrive pas à faire [en France], c’est de commencer par poser l’objet du débat. Vous ne voyez nulle part « le nucléaire, c’est quoi ? ». Si vous demandez aux Français de vous expliquer comment fonctionne une centrale nucléaire, je pense que vous allez trouver entre 1 et 5% qui sont capables de vous donner… [interrompu]

Animatrice – Oui mais ça c’est normal, non ? […] Vous ne pouvez pas demander aux Français de connaître le fonctionnement d’une centrale, si ?

JMJ – Espérer avoir un avis informé sur quelque chose dont vous ne comprenez pas le fonctionnement, c’est quand même ennuyeux, quelque part. »

Difficile quand même de donner tort à Jean-Marc Jancovici sur ce point.

Il suffit de regarder la vidéo pour se rendre compte que l’animatrice n’est pas dans l’attaque, ses questions ne sont pas faites pour provoquer comme pourrait peut-être le faire croire la transcription écrite. En revanche, elles témoignent en filigrane de cette idée reçue que le commun des mortels ne peut rien comprendre du fonctionnement d’un équipement technologique, comme si c’était peine perdue. J’insiste : ne peut rien comprendre. C’est nier qu’il existe des niveaux de compréhension pour n’importe quel type de sujet. On ne peut en revanche pas TOUT comprendre, parce qu’on peut se poser mille questions avec un niveau de détail infini. Il faut donc faire le tri et retenir l’essentiel.

Et justement, quand on voit l’essentiel, on se rend compte que non seulement, on peut demander aux Français de connaître le fonctionnement d’une centrale nucléaire, mais ce dès l’âge de 10 ans.

Alors quelques explications…

Niveau de compréhension 1 : de l’énergie nucléaire à l’énergie électrique.

(J’ai déjà consacré un article sur la notion d’énergie et ses différentes formes.)

Une centrale nucléaire se sert d’une réaction nucléaire pour faire bouillir de l’eau et entraîner une turbine à l’aide de la vapeur produite. Comme la turbine est associée à un alternateur (un aimant qui tourne devant une bobine métallique), on en tire de l’électricité. Voilà voilà.

Non, sérieusement, c’est fini. Des questions restent en suspens, mais au niveau du mode de production de l’énergie électrique, c’est déjà l’essentiel. Et le meilleur, c’est que si vous vous demandez comment fonctionne une centrale à charbon, à gaz, à fioul, c’est le même principe. On chauffe de l’eau, on met une turbine et un alternateur, et c’est tout. Et encore un bonus : pour un barrage hydraulique, on ouvre les vannes et l’eau, dans sa chute, entraîne directement la turbine. On vient de comprendre comment on exploite la fission nucléaire, les énergies fossiles et l’énergie cinétique de l’eau. D’une pierre trois coups !

Niveau de compréhension 2 : localiser les déchets produits.

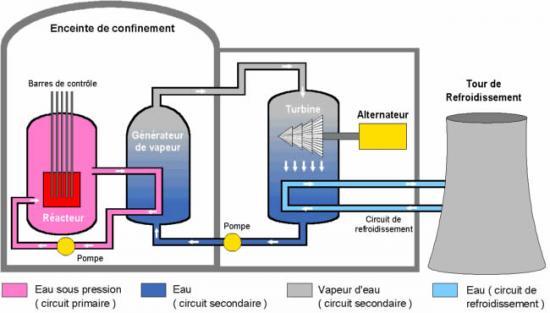

Allons à peine plus loin pour comprendre où peuvent se trouver les déchets. Regardons comment la chaîne de transformation de l’énergie est structurée dans une centrale nucléaire :

Vous voyez trois circuits d’eau (rose, bleu foncé et bleu ciel).

Le circuit primaire (rose) contient de l’eau elle-même directement en contact avec le combustible nucléaire. Les réactions de fission nucléaire la chauffent à environ 300°C, mais les hautes pressions permettent de garder cette eau sous forme liquide (Pourquoi ? Me direz-vous. Article à venir !). Cette eau contient des éléments radioactifs issus des réactions nucléaires. J’y reviendrai.

Le circuit secondaire (bleu foncé) est celui qui va permettre l’entraînement des turbines. L’eau est chauffée en la mettant en contact avec les tuyaux du circuit primaire. Comme ce circuit n’est pas sous pression, cette eau bout, s’évapore et la vapeur passe dans les turbines qui se mettent à tourner et produire l’électricité. La vapeur continue son chemin et est mise en contact avec les tuyaux du circuit de refroidissement, pour repasser à l’état liquide et boucler le cycle.

Le circuit de refroidissement fait circuler de l’eau froide issue d’une source naturelle, comme un cours d’eau par exemple. La vapeur qui résulte du contact avec le circuit secondaire est évacuée par la tour de refroidissement (les fameuses cheminées gigantesques des centrales nucléaires).

Deux points sont très importants :

1. Les trois circuits ne communiquent pas entre eux. Il n’y a jamais d’échange d’eau, juste de chaleur (une eau chauffe des tuyaux, qui chauffent à leur tour l’eau d’un autre circuit).

2. L’eau du circuit primaire n’est PAS radioactive ! Je clarifie ici un abus de langage, qui peut amener à des idées reçues. L’eau du circuit primaire est nocive car elle contient des éléments radioactifs, mais les molécules d’eau ne deviennent pas radioactives. Si vous filtrez cette eau, elle n’aura rien de particulier, elle sera potable. La radioactivité ne se transmet pas, elle ne contamine pas. Dire qu’une zone est contaminée, c’est dire que des éléments radioactifs s’y trouvent, pas que de la matière non radioactive est devenue radioactive !

Conséquence : les déchets radioactifs se trouvent dans le circuit primaire et lui seul. Le circuit secondaire n’est jamais radioactif, puisqu’il n’échange pas d’eau avec le circuit primaire. Si une fuite survient, il suffit de purger l’eau du circuit secondaire, qui, je le rappelle, n’est pas en contact avec l’environnement.

Les déchets radioactifs sont alors filtrés et stockés sous forme solide, par vitrification (c’est-à-dire piégeage dans du verre) . Les rejets de gaz à effet de serre lors du fonctionnement sont quasi-nuls [1].

J’en profite pour continuer le parallèle avec les centrales thermiques, qui ressemblent à ceci :

Même principe donc, sauf que le circuit primaire a disparu, puisque l’eau n’a pas besoin d’être en contact direct avec ce qui est brûlé (charbon, gaz, fioul).

La seule différence de taille est le rôle de la cheminée : ici, elle évacue les résidus volatiles de la combustion, donc les déchets, c’est-à-dire les gaz à effet de serre (CO2 en tête) directement dans l’atmosphère. Autrement dit, la cheminée est à raison le symbole même de la pollution pour ces centrales thermiques, mais est tout l’inverse pour une centrale nucléaire.

Niveau de compréhension 3 : source de l’énergie et nature des déchets.

L’énergie nucléaire, la radioactivité, qu’est-ce que c’est ? J’y consacrerai probablement un article plus détaillé, mais l’idée est la suivante :

L’atome est composé d’un noyau de protons et de neutrons entourés d’électrons. Des liaisons fortes, très énergétiques, existent entre les constituants du noyau pour maintenir sa cohésion. Si l’on parvient à rompre le noyau, on peut libérer cette énergie nucléaire (= qui provient du noyau). Cependant, la plupart des atomes sont stables et ne vont pas rompre facilement. Il est donc plus simple d’aller chercher du côté des atomes instables.

Un atome instable n’est… pas stable : cela veut dire que même si on le laisse seul, il va finir par se transformer en un autre atome. Pour cela, il va généralement émettre un atome d’hélium (qu’on appelle dans ce contexte particule (alpha)), un électron (particule

(bêta)) ou un rayonnement

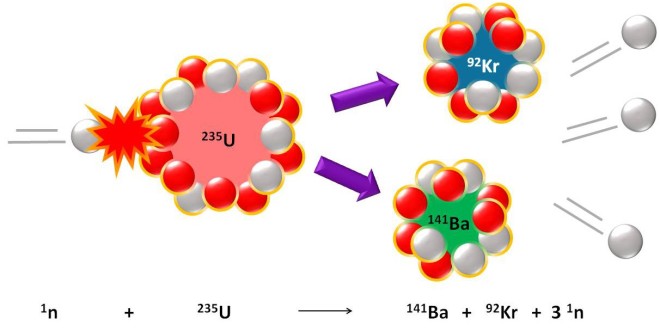

(gamma), d’où les trois types de radioactivité du même nom. L’atome d’uranium 235 est un atome instable et très massif, mais plutôt que de le laisser se désintégrer tout seul, on lui donne un petit coup de pouce. En envoyant un neutron lent, il l’absorbe et cela le perturbe énormément : il se scinde en deux gros atomes, un de baryum et un de krypton, et libère trois neutrons rapides ainsi qu’une énorme quantité d’énergie qui va chauffer le milieu environnant (l’eau du circuit primaire).

À l’arrivée d’un neutron sur le noyau d’uranium, celui-ci se scinde pour former un noyau de baryum et un noyau de krypton, ainsi que trois neutrons libres. Une importante quantité d’énergie est alors libérée.

Ralentis par l’eau, les trois neutrons peuvent à leur tour rencontrer d’autres atomes d’uranium et déclencher leur fission. On a ainsi une réaction en chaîne. Avec une quantité suffisante d’uranium 235, et si l’on ne faisait rien d’autre, la réaction s’emballerait ; dans une bombe, c’est l’effet recherché. Mais certains matériaux captent facilement les neutrons solitaires, ce qui permet de réguler la réaction. On peut ainsi régler en temps réel la vitesse de réaction en insérant plus ou moins ces barres de contrôle entre les tiges d’uranium, et donc libérer plus ou moins d’énergie selon la demande du réseau électrique. Le rendement est sans commune mesure : 1 gramme d’uranium libère à peu près autant d’énergie que la combustion d’1 tonne de charbon ! On a donc un système qui est grosso modo un million de fois plus efficace.

Les déchets nucléaires sont les résidus de la réaction ou de désintégrations secondaires, ou d’autres choses encore, comme de l’uranium 236 (un uranium qui a absorbé un neutron mais ne s’est pas scindé, ce qui peut arriver). La plupart de ces déchets sont radioactifs, certains très fortement. Une partie de ces déchets constitue une pile de « déchets ultimes », c’est-à-dire dont on ne sait qu’en faire, et donc que l’on cherche à stocker ou enfouir. Certains éléments restent actifs durant une trentaine d’années, d’autres peuvent dépasser le million d’années d’activité.

Ce qu’il ne faut pas oublier, c’est que la notion de déchet est une notion subjective et pas définitive. Si vous trouvez un moyen d’exploiter ce qui était considéré comme un déchet, ce n’en est plus un. C’est le but recherché ici. Par exemple, les centrales telles que je les ai présentées produisent inévitablement du plutonium 239. Ce dernier ne constitue pas à proprement parler un déchet nucléaire, puisque mélangé à de l’uranium 238, il donne un combustible baptisé MOX qui peut être exploité dans des centrales spécialisées. Une partie des déchets nucléaires est ainsi « recyclée ». Je vous invite aussi à vous renseigner sur le prototype de réacteur nucléaire « Superphénix », fer de lance du nucléaire français dans les années 1980, dont le principe était de pouvoir transmuter les déchets hautement radioactifs générés. Ce réacteur a cependant été arrêté du fait de pressions politiques.

Pour conclure, j’espère vous avoir fourni des clés importantes pour avoir une meilleure compréhension du nucléaire. Et bien que je ne cherche pas à créer le débat dans cet article précis, l’objet du débat, lui, est posé !

Note :

[1] (retour au texte) On pourra me rétorquer, à raison, que la vapeur d’eau est un gaz à effet de serre (même si elle est loin d’être l’espèce chimique la plus efficace en la matière). Cependant, il est évident que la vapeur d’eau est extrêmement abondante dans l’atmosphère terrestre, donc que ces rejets dus à l’activité humaine ne sont pas vraiment significatifs. De plus, la durée de séjour de la vapeur d’eau dans l’atmosphère est de trois jours en moyenne. Pour le dioxyde de carbone CO2, l’activité humaine augmente drastiquement sa concentration dans l’atmosphère (et cela va en s’accélérant), et sa durée de séjour dans l’atmosphère est d’un siècle ! C’est une autre paire de manches…

Fluorescence, phosphorescence et fluctuations quantiques du vide (I).

Dans le cadre d’un article précédent détaillant le fonctionnement d’un laser, j’ai présenté le phénomène d’émission spontanée : un atome dans un état excité, c’est-à-dire possédant un surplus d’énergie, ne reste pas dans cet état indéfiniment et restitue cette énergie en émettant de la lumière, un photon. Ce phénomène, que vous découvrez peut-être, vous est en fait familier. Il est responsable de ce qu’on appelle la fluorescence, et de la phosphorescence. Attention, les deux termes ne sont pas synonymes ! Alors quelle est la différence ?

Quand parle-t-on de fluorescence et de phosphorescence ?

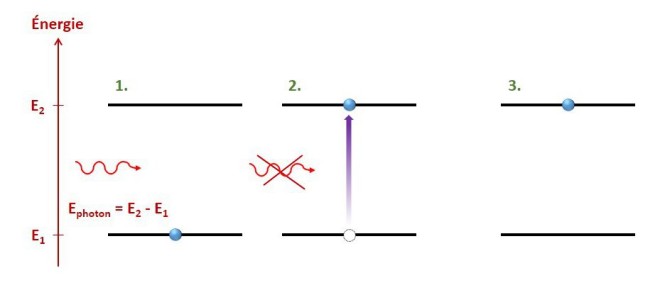

Tout d’abord, on parle de fluorescence et de phosphorescence lorsque l’on a affaire à un cycle {absorption d’un photon + émission spontanée}. Le phénomène d’absorption est en quelque sorte le contraire de l’émission spontanée : l’atome prend l’énergie du photon, qui est alors détruit, et un électron transite d’une orbitale à une autre. Attention : comme celui émis, le photon reçu possède l’énergie adéquate (), sans quoi il ne peut pas être absorbé.

1. Arrivée d’un photon de la bonne énergie sur un atome dans l’état fondamental.

2. Transition de l’électron vers une orbitale de plus haute énergie et destruction du photon.

3. Atome dans l’état excité.

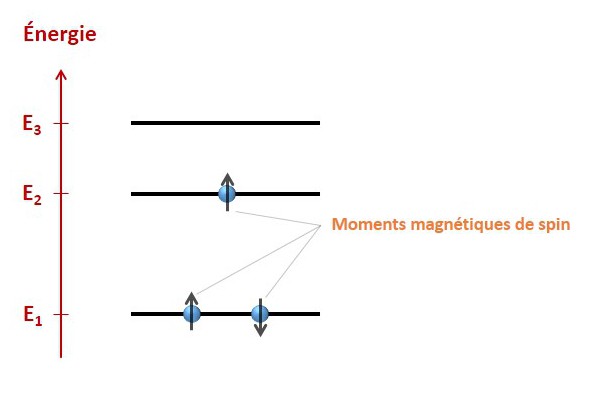

Il nous faut maintenant aller un peu plus loin en considérant deux choses : tout d’abord, le fait que le système (bien plus souvent une molécule qu’un seul atome) possède plusieurs électrons, et ensuite, le moment magnétique de spin de ces derniers.

« Le… quoi ? »

Le moment magnétique de spin. Je vais faire court et donc m’autoriser un certain nombre de raccourcis (vous voilà prévenus !). Vous connaissez la charge électrique ? C’est une propriété de la matière qui la rend sensible à la présence d’un champ électrique. Vous connaissez la masse ? Là encore une propriété de la matière, qui la rend sensible à la présence d’un champ gravitationnel. Hé bien le spin, c’est encore une autre de ces propriétés, et du spin découle le moment magnétique de spin, qui rend la matière sensible à un champ magnétique. Le moment magnétique de spin n’est pas l’équivalent d’une « charge magnétique » : il a une valeur et une orientation, là où la charge électrique et la masse se contentent d’une valeur. On le représentera donc par une flèche. Le moment magnétique de spin des électrons ne pourra prendre que deux orientations, vers le haut ou vers le bas. Quand plusieurs électrons se répartissent dans les diagrammes d’énergie que j’ai déjà montrés, ils n’ont le droit d’occuper la même orbitale qu’à une seule condition : leurs moments magnétiques doivent être d’orientations différentes. Dans le cas contraire, les états des électrons seraient rigoureusement identiques, et cela est interdit (c’est le principe de Pauli). Puisqu’ils ne peuvent être orientés que vers le haut ou le bas, il ne peut y avoir que deux électrons par orbitale.

… pour 3 niveaux et 3 électrons. L’électron sur l’orbitale 2 ne peut pas occuper l’orbitale 1, puisqu’un électron avec le même moment magnétique l’occupe déjà. La configuration représentée est donc la configuration de plus basse énergie.

On peut maintenant faire la différence…

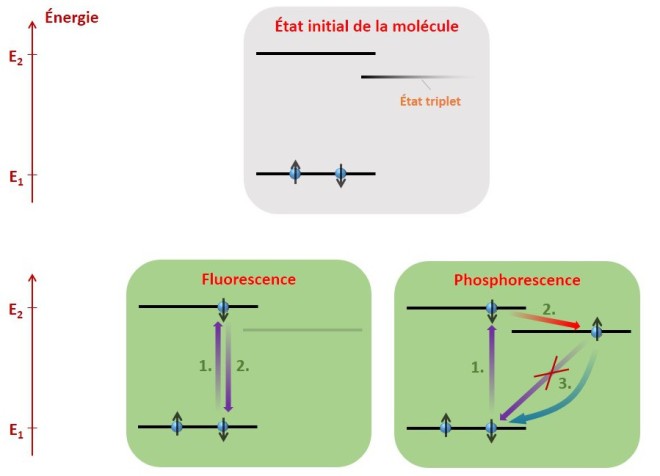

… entre fluorescence et phosphorescence.

Fluorescence : Après l’absorption d’un photon, l’électron excité retourne à l’état fondamental en en réémettant un. Rien de particulier ne se passe au niveau du spin. Le processus ne dure alors que quelques nanosecondes, autant dire qu’à notre échelle de perception, il est instantané. Ce qui veut dire aussi qu’un objet fluorescent ne peut pas être lumineux dans le noir !

Phosphorescence : Cette fois-ci, pour des raisons que je ne détaillerai pas, l’électron excité transite dans un autre niveau d’énergie particulier (un état dit triplet), où son spin s’est retourné. Il est donc bloqué dans cet état d’énergie ! En effet, le niveau d’énergie plus basse est déjà occupé par un électron de même spin, il lui est donc interdit d’y retourner. Il va quand même y parvenir, en se désexcitant et en retournant son spin simultanément. Ce processus aléatoire est cependant bien plus rare, et peut prendre des secondes, voire des heures ! Résultat, une fois qu’on a éclairé un matériau phosphorescent, celui-ci diffuse de la lumière au fur et à mesure que ses molécules parviennent à retourner à l’état fondamental. Plus on l’aura éclairé longtemps au préalable, plus il sera lumineux, puisqu’un nombre plus important de molécules se seront « coincées » dans l’état triplet. Les deux phénomènes sont résumés sur le schéma suivant :

Fluorescence :

1. Absorption d’un photon.

2. Réémission du photon.

L’état triplet ne joue aucun rôle.

Phosphorescence :

1. Absorption du photon.

2. Retournement de spin (passage dans l’état triplet).

3. Un photon ne peut être réémis immédiatement (la transition classique est interdite).

L’électron doit effectuer la transition en retournant son spin, ce qui est beaucoup moins probable et peut arriver plusieurs heures après l’absorption. De ce fait, l’objet reste lumineux un certain temps dans le noir.

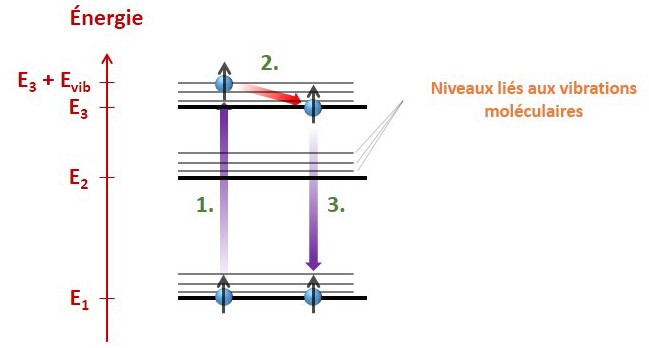

Un dernier point notable est qu’en réalité, la lumière absorbée et la lumière réémise ne sont pas forcément identiques. Cela vient du fait que la structure électronique des molécules est encore un peu plus riche que ce que j’ai précédemment présenté. Les molécules peuvent en effet vibrer, avec une certaine énergie. Ainsi, des sous-niveaux vibratoires existent, pour chaque niveau électronique, comme illustré ci-après.

1. La molécule absorbe un photon d’énergie E3 + Evib – E1, ce qui porte l’électron dans l’état correspondant.

2. L’énergie Evib liée à la vibration est très rapidement perdue par la molécule, et cédée à son environnement en quelques picosecondes (millionième de millionième de seconde). Il n’y a pas d’émission de photon.

3. L’électron retombe dans l’état fondamental, et émet un photon d’énergie E3 – E1. Ce photon est d’énergie inférieure, donc de longueur d’onde supérieure (les deux quantités sont inversement proportionnelles).

Il est ainsi possible à une molécule d’absorber dans l’ultraviolet et de réémettre dans le spectre visible.

Les vibrations de la molécule s’atténuent rapidement en percutant les molécules voisines. De fait, l’énergie liée à ces vibrations est très rapidement perdue sans rayonner. Puis, une transition classique s’effectue en émettant un photon. Mais puisque les niveaux impliqués diffèrent entre l’absorption et l’émission, l’énergie du photon émis est inférieure à celle du photon absorbé. Et voilà comment vous devenez lumineux en boîte de nuit, si vous portez des vêtements blancs, lorsque l’on vous éclaire en « lumière noire » : les ultraviolets, qui ne sont pas perçus par l’œil humain, sont absorbés par les molécules fluorescentes et réémis dans le spectre visible, principalement le bleu. À noter d’ailleurs que les molécules fluorescentes en question ne constituent pas vos vêtements, elles proviennent des agents blanchissants contenus dans votre lessive, ou agents azurants.

Enfin, fluorescence ne rime pas avec toxicité. La plupart des molécules fluorescentes sont dites aromatiques, elles ont une structure chimique spécifique. Mais, avec ce nom, vous vous doutez bien qu’une partie d’entre elles est responsable des arômes que nous percevons (j’ai bien dit cependant « une partie d’entre elles »). En outre, si l’on met une boisson tonique sous éclairage ultraviolet, ça donne le résultat ci-contre. Pourquoi ? Parce que la quinine qu’elle contient est fluorescente, et ça ne cause pas de problème de santé pour autant.

Enfin, fluorescence ne rime pas avec toxicité. La plupart des molécules fluorescentes sont dites aromatiques, elles ont une structure chimique spécifique. Mais, avec ce nom, vous vous doutez bien qu’une partie d’entre elles est responsable des arômes que nous percevons (j’ai bien dit cependant « une partie d’entre elles »). En outre, si l’on met une boisson tonique sous éclairage ultraviolet, ça donne le résultat ci-contre. Pourquoi ? Parce que la quinine qu’elle contient est fluorescente, et ça ne cause pas de problème de santé pour autant.

Quid des « fluctuations quantiques du vide » ? Elles viendront dans le prochain article !

Le laser, machine à dupliquer les photons

Dans cet article, je vais m’intéresser à cette machine fascinante dont tout le monde entend parler régulièrement, et qui est omniprésente dans les laboratoires : le laser ! Ah… sauf que ça commence mal : le LASER, à la base, ce n’est pas une machine, c’est un concept ! Mais on a vite appelé laser le dispositif qui exploite le concept du LASER. Bon, bref, commençons donc par expliquer le concept.

Concept du LASER.

Le LASER, et c’est pour cette raison que je l’écris en majuscules, est un acronyme pour « Light Amplification by Stimulated Emission of Radiation », soit en français « Amplification de Lumière par Émission Stimulée de Rayonnement » (ALESR, ça n’est pas très beau !). Il me faudra donc détailler un peu ce qu’est ce processus d’émission stimulée et comment on s’en sert pour amplifier la lumière.

Peut-être certains d’entre vous réagissent à l’évocation du mot anglais « radiation », mais il n’y a pas lieu de s’alarmer. Ce que l’on désigne par radiation, c’est simplement une onde électromagnétique, et ce indépendamment de son caractère nocif ou non (c’est pour cette raison qu’on le traduit plutôt par rayonnement, en français). La lumière est un cas particulier de radiation, possédant une longueur d’onde comprise entre 380 nm et 780 nm. Autrement dit, il est tout-à-fait normal de dire qu’une simple lampe de chevet vous irradie, juste parce qu’elle vous éclaire ! Les deux mots sont synonymes mais le mot français « radiation » est connoté, car il renvoie à la notion de radioactivité, qui elle a tendance à être nocive (mais il y a beaucoup de choses à en dire, et cela fera peut-être l’objet d’un article).

Bien que le phénomène d’émission stimulée soit au cœur du concept du LASER, un autre phénomène en permet le déclenchement : l’émission spontanée. Pour savoir de quoi il s’agit, il faut aller voir ce qui se passe à l’échelle atomique.

Émission spontanée et émission stimulée.

Pour faire assez court, l’atome est constitué d’un noyau de protons et de neutrons autour duquel se trouvent des électrons. Les électrons occupent des orbitales bien précises, mais soyons clairs ici : « orbitales » n’a pas le sens d’orbite, et nous savons qu’un atome ne se comporte pas comme un système solaire miniature. Néanmoins, ce modèle physique, bien que faux, est déjà suffisamment raffiné pour nous permettre de comprendre les phénomènes d’émission spontanée et d’émission stimulée. Donc vous pouvez garder cette vision de l’atome pour cette fois si vous voulez vous représenter les choses de cette façon, en retenant que les choses sont en vérité plus subtiles.

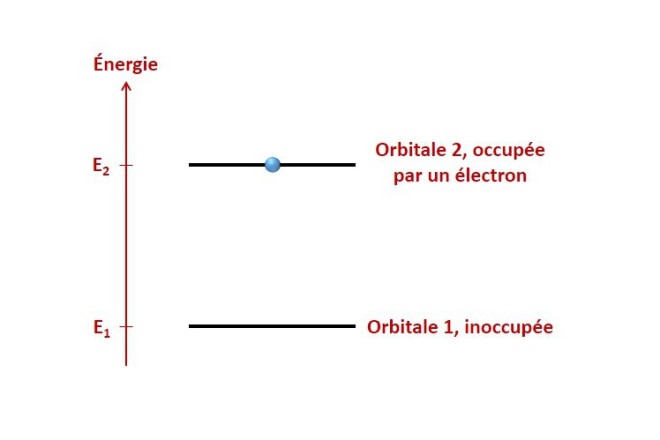

Un électron donné ne peut pas avoir n’importe quelle « orbite », seules certaines sont permises, et lorsque l’électron occupe une orbitale précise, il possède une quantité d’énergie précise qui y est associée. Pour décrire l’état d’un électron de l’atome, on peut ainsi complètement oublier l’orbitale qu’il occupe et se focaliser sur l’énergie qu’il possède. On peut alors représenter l’état de l’électron à l’aide d’un diagramme très simple :

L’émission spontanée et l’émission stimulée correspondent alors à deux types de transitions de l’électron dans ce diagramme.

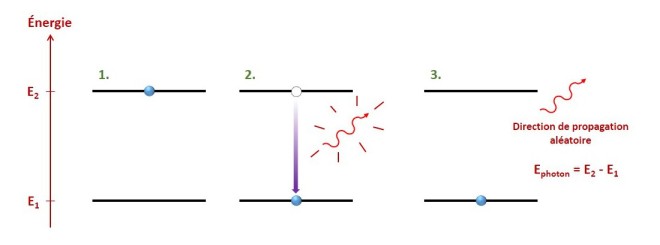

– Émission spontanée : Imaginons que l’atome soit excité, c’est-à-dire que l’on a fourni au préalable de l’énergie à l’électron, peu importe comment, de manière à ce qu’il occupe une certaine orbitale. Cet électron va chercher à retourner à un état de plus basse énergie. Pourquoi ? La réponse a cette question est, de mon point de vue, fascinante et je la traiterai dans un autre article. Bref, l’électron veut « redescendre » dans le diagramme. Pour cela, il se débarrasse d’un excédent d’énergie et « saute » à l’orbitale inférieure. Cet excédent d’énergie ne disparaît évidemment pas (souvenez vous : l’énergie ne varie pas au cours du temps !), il est converti en lumière. Autrement dit, l’électron crée un photon possédant une énergie très précise au moment où il transite d’une orbitale à une orbitale de plus basse énergie. Ce photon est alors émis dans une direction aléatoire.

1. Atome dans l’état excité.

2. Transition de l’électron vers une orbitale de plus basse énergie et émission d’un photon.

3. Le photon se propage dans une direction aléatoire et son énergie correspond à l’énergie perdue par l’électron entre les deux orbitales.

Note : c’est le phénomène qui permet aux ampoules (lampes à incandescence) de nous éclairer. Un courant électrique circule dans un filament métallique de tungstène et le chauffe à blanc (l’ampoule, c’est-à-dire la bulle de verre, est sous vide ce qui empêche la combustion du filament, du fait de l’absence de dioxygène). Les atomes ainsi excités émettent de la lumière par émission spontanée. La lumière émise n’est pas monochromatique, car il existe de nombreux niveaux d’énergie, donc de nombreuses transitions possibles. Les photons émis n’ont donc pas la même énergie selon la transition qui leur a donné naissance.

Note : c’est le phénomène qui permet aux ampoules (lampes à incandescence) de nous éclairer. Un courant électrique circule dans un filament métallique de tungstène et le chauffe à blanc (l’ampoule, c’est-à-dire la bulle de verre, est sous vide ce qui empêche la combustion du filament, du fait de l’absence de dioxygène). Les atomes ainsi excités émettent de la lumière par émission spontanée. La lumière émise n’est pas monochromatique, car il existe de nombreux niveaux d’énergie, donc de nombreuses transitions possibles. Les photons émis n’ont donc pas la même énergie selon la transition qui leur a donné naissance.

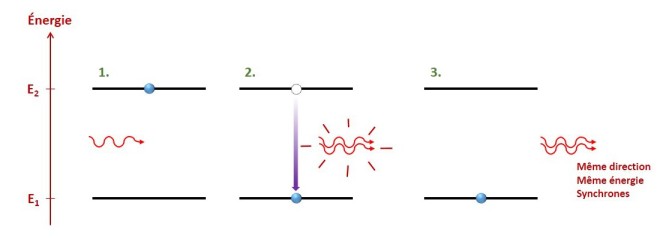

– Émission stimulée : L’émission stimulée est un processus très proche de l’émission spontanée. On part de la même situation (un atome dans un état excité), mais cette fois-ci, au lieu d’attendre que l’électron transite tout seul, on imagine qu’un photon de la bonne énergie passe par là. Ce passage va déclencher la transition de l’électron, et il va ainsi émettre son photon, mais pas n’importe comment : le photon émis va être une copie conforme du premier photon qui passait. Il est synchronisé avec lui et se propage dans la même direction. Ces deux caractéristiques sont importantes. Les deux photons sont dans le même état et la lumière se trouve renforcée.

1. Atome dans l’état excité et arrivée d’un photon ayant la bonne énergie (E2 – E1).

2. Transition de l’électron vers une orbitale de plus basse énergie et émission d’un photon « jumeau ».

3. Le second photon est une parfaite réplique du premier. Il se propage donc dans la même direction, possède la même énergie, et est synchronisé avec lui (ils sont « en phase »).

Et si maintenant on cherchait à mettre des millions, des milliards de photons dans le même état ? Comment optimiser le phénomène ? Hé bien le laser est justement le dispositif qui sert à faire cela !

Le dispositif laser.

L’idée est simple : on veut favoriser autant que possible le processus d’émission stimulée. Pour cela, il faut…

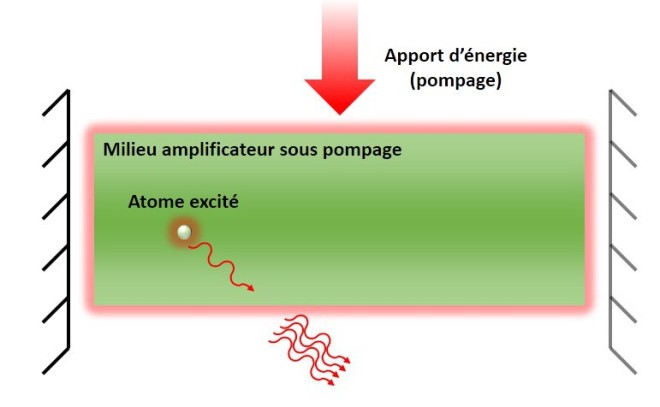

1. … des atomes. Ils vont former ce que l’on appelle un milieu amplificateur. Historiquement, le tout premier laser date de 1960, et avait pour milieu amplificateur un cristal de rubis. Mais les dispositifs laser peuvent être extrêmement variés, et le milieu amplificateur peut être un solide, un liquide ou même un gaz. Évidemment, la nature des atomes va jouer sur la lumière émise (la différence d’énergie entre deux orbitales ne va pas être la même).

2. … de l’énergie. Souvenez-vous que les atomes ne doivent pas se trouver dans leur état fondamental (leur état de plus basse énergie), sinon ils ne pourront pas émettre de lumière. Cet apport d’énergie extérieur est appelé pompage. Là encore, les méthodes de pompage sont très variées (décharges électriques, illumination par des flashs lumineux, etc.).

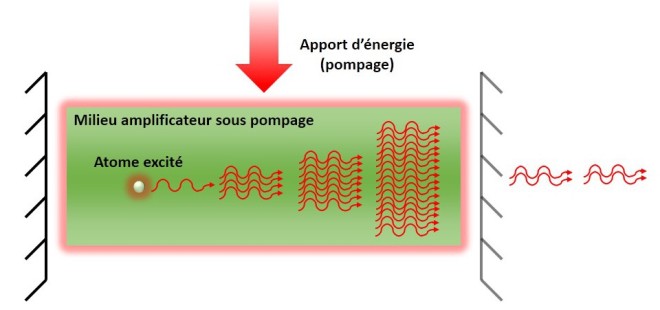

3. … que les photons rencontrent le plus possible d’atomes excités sur leur passage. Pour cela, on aimerait qu’ils restent dans le milieu amplificateur, sauf qu’évidemment, les photons se propageant en ligne droite, ils ne s’amusent pas à faire des détours à l’intérieur. Alors piégeons-les, ces photons : coinçons-les dans le milieu amplificateur à l’aide de deux miroirs qui se font face, de manière à ce qu’ils fassent indéfiniment des allers-retours. Hé bien voilà, on a une cavité laser. Le flux de photons va ne faire que se multiplier à l’identique à l’intérieur : le laser n’est rien d’autre qu’une machine à dupliquer les photons !

4. … laisser quelques-uns de ces photons sortir de la cavité, quand même ! Sinon, nous ne pourrions pas faire grand-chose avec ce faisceau laser. Les photons sont forcés de se propager dans l’axe de la cavité (perpendiculairement aux miroirs), puisqu’ils copient le photon qui a été piégé en premier lieu. Pour qu’ils puissent s’échapper, la solution consiste à se servir d’un miroir partiellement réfléchissant, qui réfléchit un certain pourcentage de photons et laisse passer le reste. Selon les types de laser, on peut trouver des miroirs de cavité réfléchissant la lumière à hauteur de 30%, mais aussi jusqu’à 99%. Dans ce dernier cas, songez que le faisceau est cent fois plus puissant à l’intérieur de la cavité qu’en sortie !

De l’allumage à l’obtention du faisceau en sortie.

Nous avons déjà quasiment tous les éléments pour comprendre le fonctionnement d’un dispositif laser. Mais comment force-t-on les photons à faire ce qu’il faut ? On voit bien que l’étape 3, le piégage des photons dans la cavité, ne se fait pas comme par hasard, si ?

Hé bien… si ! On laisse justement faire le hasard.

Allumer le dispositif, c’est commencer le pompage : les atomes du milieu amplificateur acquièrent cette énergie qu’on leur donne et passent dans l’état excité. À partir de cet instant, les émissions spontanées apparaissent, et les atomes relâchent l’énergie acquise sous forme lumineuse dans n’importe quelle direction. Ces photons peuvent être dupliqués en rencontrant d’autres atomes excités, mais peu importe, ils quittent rapidement le milieu amplificateur et se perdent dans la nature.

En revanche, de temps en temps, par le fait du hasard, un photon est émis dans la bonne direction et se met à rebondir entre les miroirs. Il est alors de plus en plus dupliqué. S’il est perdu, pour diverses raisons (absorption, diffusion, traversée du miroir semi-réfléchissant, etc.), c’est déjà « trop tard » : des centaines, milliers ou plus de photons identiques le remplacent. L’amplification s’auto-entretient et domine tous les autres processus existants. Chaque atome excité a en effet beaucoup plus de chances de copier l’un des innombrables photons du faisceau laser qu’un pauvre photon unique issu d’une émission spontanée. Tout ce qui compte, c’est de continuer à fournir de l’énergie au milieu amplificateur pendant ce temps-là, sans quoi il ne peut plus rien amplifier. L’onde laser, elle, s’établit d’elle-même en moins d’une microseconde !

Pourquoi avoir voulu fabriquer le laser ?

C’est là la question la plus drôle, parce que la réponse pourrait tenir en trois mots : pour le fun !

Le laser a été fabriqué simplement a un moment où les connaissances et les moyens techniques étaient suffisants pour pouvoir y arriver. On le fait parce qu’on pense pouvoir le faire, donc si on essayait ! C’est le côté exploratoire de la recherche qui est perceptible ici ; réaliser une innovation technologique pour la réaliser. Soyons clairs tout de même : même au-delà de constituer une démonstration expérimentale de l’émission stimulée (décrite par Einstein en 1917), les chercheurs de l’époque ont bien des idées de l’utilité d’un laser, surtout que le maser (dispositif similaire pour les ondes de la gamme micro-ondes) a été mis au point cinq ans plus tôt. Pour le grand public et les auteurs de Science-Fiction, l’idée du laser existe déjà depuis longtemps. Mais malgré tout, le laser ne répond à aucun besoin de l’époque, il est considéré pendant plusieurs années comme rien de plus qu’un jouet. « Nous avons l’habitude d’avoir un problème et de chercher une solution. Dans le cas du laser, nous avons déjà la solution et nous cherchons le problème. » Depuis, des problèmes de natures variées, il en résout un sacré paquet !

L’intérêt du laser est de produire une lumière plus « pure » que la lumière naturelle. Une lumière dite cohérente. Cette cohérence vient justement du fait que les photons qui constituent le faisceau sont des copies conformes les uns des autres, ce qui n’est pas le cas pour des sources naturelles. Mais j’y reviendrai (plus tard !).

Note : les lasers peuvent être extrêmement variés. Le domaine technique qu’ils couvrent est vraiment très très vaste et il pourrait y avoir cinquante articles dessus. Mais le but de cet article-ci est de présenter l’idée de base qui se cache derrière tout laser, l’essentiel.

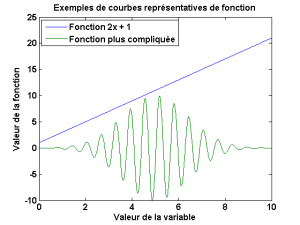

Un outil mathématique incontournable – la fonction

Cet article est le premier d’une série d’articles mathématiques qui me permettront de détailler le fonctionnement de plusieurs outils mathématiques très utiles en physique. C’est aussi l’occasion de montrer qu’il y a bien une cohérence entre ces outils, qu’on peut les utiliser pour en bâtir de nouveaux. Je précise d’avance aussi que je n’aurai pas une rigueur de mathématicien. Mon but est de présenter assez simplement ces outils et comment ils permettent d’aller plus loin, ainsi que leur utilité en physique. Ici, je m’attarde sur la notion de fonction, une notion de base qui donne naissance à toute une branche des mathématiques, l’analyse.

Une fonction, qu’est-ce que c’est ?

Une fonction , c’est une action, un mode d’emploi, une recette à appliquer à un nombre pour en obtenir un autre.

peut être par exemple « multiplier par 2 et ajouter 1 ». Appliquée au nombre 3, elle donne 7. On écrit donc

. Si l’on dispose d’une inconnue

,

est un nombre et vaut

. La signification de

est donc claire : c’est un nombre, et pour l’obtenir je prends le nombre

et je lui applique la recette « multiplier par 2 et ajouter 1 ». Qu’est-ce qu’elle apporte ?

– C’est un tout nouvel objet mathématique. Lorsque vous n’avez que les nombres, vous ne pouvez raisonner que sur les nombres, établir leurs propriétés. Si vous avez les fonctions, alors vous pouvez commencer à explorer les propriétés des « recettes » de nombres elles-mêmes. Par exemple, on peut trouver des fonctions paires, si pour n’importe quel nombre

,

. Connaître cette propriété pour une fonction que l’on utilise peut permettre des simplifications de calcul ou de raisonnement.

– Elle met en avant le lien qui peut unir plusieurs quantités. Par exemple, le volume d’une sphère dépend de son rayon

. Le volume est donc une fonction

.

– Elle possède une représentation graphique. Pour cela, on trace une courbe représentative, dont chaque point correspond à la valeur que possède la fonction pour la valeur choisie de sa variable. Cette représentation permet d’avoir une vue d’ensemble des valeurs prises par la fonction, de la façon dont elle évolue, de là où elle atteint des valeurs particulières. Bref, elle facilite généralement la perception que l’on se fait d’une fonction.

– Elle peut permettre d’améliorer la lisibilité d’une équation. Le volume d’une sphère est , et s’il intervient dans une équation assez compliquée, le remplacer simplement par «

» permet d’en alléger l’écriture sans en perdre de vue la signification des différents termes qui la composent.

Nous disposons donc maintenant d’un outil mathématique permettant l’étude des « recettes » de nombres. Dans certaines situations, on étudie une quantité (la vitesse d’une voiture par exemple) et on s’intéresse à l’évolution de cette quantité par rapport à un paramètre (l’évolution de la vitesse au cours du temps, ce qu’on appelle l’accélération). Comment remonte-t-on à cette évolution d’un point de vue mathématique ? C’est l’objet du prochain article, et bien sûr, les fonctions seront utiles !

Qu’est-ce que l’énergie ?

L’énergie. C’est un concept omniprésent, assez insaisissable, mais central en physique. Et étonnamment, il n’est pas simple du tout d’en donner une définition de but en blanc. J’ai donc décidé de faire un petit tour sur quelques dictionnaires d’Internet pour voir ce qu’ils en disent, en éliminant les définitions inapplicables en sciences :

– Grandeur, dont l’unité est le joule, qui caractérise un système et qui exprime sa capacité à modifier l’état d’autres systèmes en interaction avec lui.

– Chacun des modes que peut présenter un tel système (énergie cinétique, énergie mécanique, énergie thermique,…).

– Grandeur caractérisant un système physique, gardant la même valeur au cours de toutes les transformations internes du système (loi de conservation) et exprimant sa capacité à modifier l’état d’autres systèmes avec lesquels il entre en interaction. (Unité SI le joule.)

De mémoire, j’avais aussi lu que l’énergie était la « capacité d’un corps à fournir du travail ». Le travail en physique correspondant à un transfert d’énergie, pas sûr que cette définition aide vraiment à comprendre !

Voici celle que je proposerais, pour l’instant incomplète :

L’énergie est une grandeur physique dont l’unité est le joule (J). Quelle que soit la nature du système physique à l’étude, il est toujours possible d’en dégager une expression mathématique homogène à une énergie.

« Homogène à » signifie « qui possède la même unité que ». Ma définition vous déçoit peut-être, car vous la considérez peut-être toujours aussi abstraite – sinon plus ! – que les autres. La raison en est que le concept même d’énergie est un concept abstrait, alors même que le terme « énergie » est omniprésent au quotidien et si utilisé que chacun semble y saisir un sens concret ! Mais il suffit de se pencher sur la question de sa définition pour que le terme devienne justement insaisissable tant il est flou. Et j’ai inclus dans ma définition la source de cette indétermination : l’énergie est une quantité qui émane du calcul !

Cette quantité possède deux caractéristiques, indispensables pour la reconnaître. La première est son unité, qui est toujours le joule. J’aborderai la seconde, l’invariance au cours du temps, un peu plus tard et cela me permettra de compléter ma définition.

Plusieurs formes d’énergie.

Un point important de la définition que je propose est que, puisqu’il est possible de calculer une énergie pour n’importe quel système physique, tout système physique possède une énergie. Cela n’empêche pas que le type de cette énergie, son expression mathématique, diffère d’un système à l’autre selon la nature de ce système : une pile et un objet en mouvement possèdent chacun une certaine quantité d’énergie, mais pas du même type. D’où le fait que le concept d’énergie n’a aucune signification que l’on peut rendre plus concrète ; il se décline en fait en de nombreux types d’énergie distincts. Je les ai regroupés en trois grandes catégories.

Énergies au sens physique.

Ce sont les différentes notions d’énergie directement utilisées par le physicien.

– Énergie cinétique : énergie que possède un objet du fait de son mouvement.

– Énergie thermique : énergie que possède un objet du fait de sa température. La température est une mesure du degré d’agitation qui règne au niveau nanoscopique. Elle est donc elle aussi en toute rigueur une énergie cinétique. Cependant, elle possède un statut particulier qui justifie de la considérer comme un type d’énergie à part entière : la conversion d’une énergie quelconque en énergie thermique est irréversible, contrairement à d’autres types de conversion.

– Énergie chimique : énergie impliquée dans les liaisons chimiques des molécules.

– Énergie gravitationnelle : énergie contenue dans les déformations de l’espace-temps. Ces déformations peuvent se propager, elles forment des ondes gravitationnelles que nous essayons actuellement de détecter pour en confirmer l’existence.

– Énergie potentielle : c’est un concept un peu plus délicat que les autres. C’est l’énergie qui peut être potentiellement échangée entre le système à l’étude et son environnement. Par exemple, je peux tenir une balle dans la main à une certaine hauteur. La balle peut donc potentiellement tomber, et l’attraction terrestre lui fournir de l’énergie au cours de sa chute. Le simple fait de tenir une balle dans un champ gravitationnel fait qu’elle possède une énergie potentielle, qu’elle pourra convertir (ici en énergie cinétique) si on la laisse évoluer dans ce champ. Dans cet exemple, l’énergie potentielle décrite est l’énergie potentielle de pesanteur. Il existe d’autres types d’énergie potentielle.

– Énergie électromagnétique : énergie que possède tout champ électrique ou magnétique.

– Énergie nucléaire : énergie impliquée dans les liaisons responsables de la cohésion du noyau atomique.

– Énergie noire (ou sombre) : c’est une énergie hypothétique distribuée dans l’univers, dont l’origine n’est pas encore connue, que les chercheurs ont introduit pour chercher à expliquer l’accélération de l’expansion de l’univers. C’est un sujet de recherche central en astrophysique.

Énergies au sens usuel.

Ce sont diverses dénominations qui renseignent sur l’origine et les moyens d’exploitation de l’énergie dont on parle.

– Énergie éolienne : énergie provenant du vent, donc de masses d’air en mouvement. C’est donc une énergie cinétique.

– Énergie fossile : énergie tirée de la combustion des hydrocarbures du sous-sol. C’est donc une énergie chimique.

– Énergie géothermique : énergie tirée de la température élevée du sol du fait de la radioactivité naturelle et des activités volcaniques. C’est donc une énergie thermique.

– Énergie houlomotrice : énergie tirée de la houle, c’est-à-dire de vagues se propageant à la surface de la mer. C’est une énergie cinétique.

– Énergie hydraulique : énergie tirée d’un écoulement d’eau. C’est une énergie cinétique.

– Énergie marémotrice : énergie tirée des marées. C’est une énergie cinétique.

– Énergie solaire : énergie tirée de la lumière du Soleil. C’est une énergie électromagnétique.

– Énergie électrique : énergie tirée d’un courant électrique, c’est-à-dire d’un mouvement d’électrons. C’est une énergie cinétique.

Énergies au sens politique.

Ce sont des catégories d’énergie, qui regroupent les énergies déjà évoquées selon des enjeux sociétaux. Au niveau des sources utilisées, la majorité des liens Wikipédia résulte du fait que j’y ai trouvé les définitions les plus fiables et les mieux formulées à mon humble avis.

– Énergie renouvelable : désigne une forme d’énergie dont la ressource ne s’épuise pas sur une échelle de temps humaine. (source 1, source 2)

– Énergie propre (ou verte) : désigne une forme d’énergie dont l’impact sur l’environnement est faible. (source 1, source 2)

– Énergie durable : énergie capable de répondre aux besoins du moment présent sans compromettre la capacité des générations futures à répondre à leurs propres besoins. (source)

– Énergie primaire : désigne une forme d’énergie disponible dans la nature avant toute transformation. (source)

– Énergie finale : énergie au stade final de la chaîne de transformation de l’énergie, c’est-à-dire au stade de son utilisation par le consommateur final. (source)

Utilité d’une quantité invariante.

Qu’est-ce qui intéresse tant le physicien dans le concept d’énergie ? La raison, c’est son invariance au cours du temps. Si vous étudiez un système isolé, c’est-à-dire qui n’influence pas et n’est pas influencé par son environnement, vous savez que son énergie totale ne varie pas, quoiqu’il arrive. Analyser un problème physique du point de vue des énergies permet parfois d’emprunter des raccourcis qui évitent un traitement complexe de la situation.

Mais revenons au caractère invariant, en quoi est-ce si intéressant ? Dans beaucoup de phénomènes physiques, on observe l’évolution d’un système depuis un état initial jusqu’à un état final. Si l’on connaît les mécanismes physiques qui interviennent dans cette transition, on peut envisager de mener l’étude de façon directe, mais cela ne garantit pas qu’elle sera simple. On peut souvent se heurter à des difficultés techniques, comme une grande complexité mathématique. Cependant, si l’on a identifié une quantité physique invariante, c’est-à-dire n’ayant pas changé de valeur entre les états initial et final, on peut déduire l’état final (ou pourquoi pas, l’état initial) de l’état initial (respectivement final) sans forcément passer par toute l’étude intermédiaire.

Prenons deux exemples. Le premier sera simplissime juste pour illustrer l’idée, le second montrera un peu plus l’apport de la démarche.

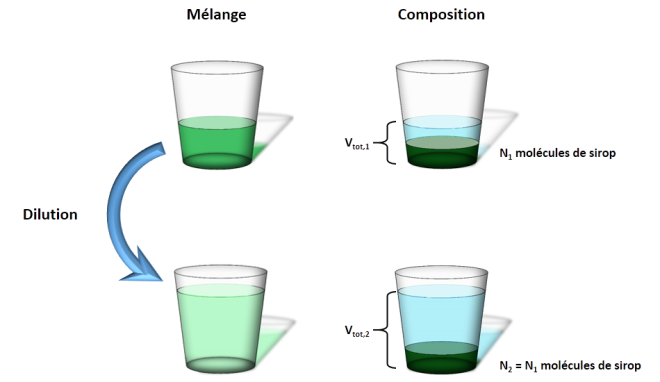

Prenez un verre dans lequel vous versez un peu de sirop de menthe, suivi d’un peu d’eau. Le mélange aura une couleur verte foncée, le goût de menthe sera fort. Si vous rajoutez de l’eau, le mélange s’éclaircit et le goût sera moins prononcé. Ce sont les conséquences d’une dilution : la concentration en menthe aura diminuée. Cette concentration est mesurable, comment prédire sa valeur pour un volume d’eau ajouté donné ? Dire que la concentration est divisée par deux quand on double la quantité d’eau n’est pas vrai ! Mais peu importe la loi empirique, elle doit bien avoir une origine.

En fait, il suffit de penser aux molécules de sirop dans le verre. Quand on ajoute de l’eau, que se passe-t-il ? Pas grand chose ! Elles se répartissent simplement dans tout le volume de liquide. Leur nombre ne varie pas au cours de l’expérience. Donc en appelant les états initial et final, les états 1 et 2, ainsi que le nombre de molécules de sirop, je dis

.

Ensuite, par définition, je sais que la concentration est le nombre de molécules par unité de volume, . J’en déduis la relation :

.

C’est la loi de dilution. Vous voyez que, sans trop se poser de questions, elle découle simplement du fait que dans toute dilution, le nombre de molécules d’une espèce chimique donnée est un invariant.

Et si il y avait eu une réaction chimique ? La relation précédente n’aurait plus été vraie, mais le nombre d’atomes de chaque type impliqué dans la réaction (de l’hydrogène, du carbone, etc.) aurait toujours été conservé, ce qui permet toujours de dire des choses.

Et si il y avait eu une réaction nucléaire ? Les invariants précédents n’auraient plus été invariants, mais l’énergie totale, le nombre total de charges électriques et d’autres quantités seraient toujours restées invariantes ! Et ainsi de suite. En allant vers des phénomènes de plus en plus complexes, les quantités qui y demeurent invariantes peuvent être de plus en plus subtiles, mais elles existent et fournissent leur lot d’informations.

Prenez deux objets que vous faites se percuter. On ne s’intéresse qu’à la collision pure et rien d’autre, en oubliant toute influence de l’environnement. Pour que la situation physique soit encore plus simple, on va dire que ces deux objets sont astreints à se déplacer le long d’un axe (par exemple, à l’intérieur d’un tube) et qu’ils ne peuvent pas tourner sur eux-mêmes. Les mouvements, de même que l’étude mathématique, qui vont en résulter seront simples.

On va de plus supposer que l’un des deux objets sera plus massif que l’autre pour les distinguer. Pour l’objet massif, on notera toutes les quantités physiques qui le concernent avec une majuscule : son énergie cinétique , sa quantité de mouvement

, sa masse

et sa vitesse

. Pour l’objet moins massif, ce sera respectivement

,

,

et

. Qu’est-ce que la quantité de mouvement

? C’est simplement le produit de la masse par la vitesse

. Il se trouve que c’est aussi une quantité invariante.

L’énergie cinétique vaut

.

Quand chacun de ces deux objets se déplacent indépendamment, ils constituent deux systèmes isolés indépendants : l’énergie que chacun possède, purement cinétique, ne peut pas changer. Ils se déplacent donc perpétuellement, à vitesse constante, dans une direction donnée. Au moment d’une collision, ce n’est plus le cas. Les deux systèmes ne sont plus isolés puisque justement, il se produit quelque chose entre eux : la collision elle-même. Un transfert d’énergie (et de quantité de mouvement) de l’un des objets à l’autre peut s’opérer. En revanche, l’ensemble des deux objets est toujours un système isolé, donc l’énergie totale du système, ainsi que sa quantité de mouvement totale, n’ont pas eu le droit de changer.  Et on peut tirer parti de ce fait pour prédire les états de mouvement des deux objets après le choc en fonction de la situation avant le choc.

Et on peut tirer parti de ce fait pour prédire les états de mouvement des deux objets après le choc en fonction de la situation avant le choc.

En rajoutant un indice pour initial et

pour final, le bilan d’énergie totale s’écrit

donc

.

Celui de la quantité de mouvement totale s’écrit

soit

.

Après un peu de reformulation mathématique, on peut aboutir à

.

Ainsi, connaissant les masses des deux objets, la connaissance de leurs vitesses initiales respectives suffit pour prédire leur mouvement futur. Remarquez que vous n’avez même pas à décrire le processus de collision (bien que cela soit dû au fait que la situation physique est très simple) ! En effet, une collision, ce n’est pas forcément le contact physique entre deux objets tel que vous pouvez l’imaginer, comme deux billes qui s’entrechoquent. Si vous envoyez deux particules chargées qui se repoussent l’une sur l’autre, elles se dévieront mutuellement sans contact, juste par l’intermédiaire de leur champ électrique. C’est pourtant une collision. Ici, le résultat ne dépend pas de la nature de la collision. Qu’elle provienne d’un contact direct, d’une répulsion électrique, d’une répulsion magnétique ou autre, le résultat sera toujours le même à la fin.

Note : pourquoi avoir montré quelques équations ? La raison principale est que je préfère ne pas les dissimuler. Les mathématiques sont l’outil du physicien et ce qui précède montre comment il s’en sert, expose la démarche qui va avec. D’abord, on formule le problème en termes mathématiques. Puis, on le résout (c’est cette partie qui demande une réelle expertise mathématique, et qui n’a pas forcément d’intérêt à être montrée). Enfin, on questionne le résultat, d’où on peut extraire toutes sortes d’informations.

Une autre raison, spécifique à ce sujet, est que, au prix de petites manipulations mathématiques, le lecteur peut lui-même utiliser le résultat pour s’amuser (si si, pourquoi pas ?). Mettons que vous ayez deux boules de billard de masse et

. Si vous en frappez une pour percuter l’autre de front (en visant centre à centre donc, pour ne pas percuter de côté), vous pourrez appliquer les formules que j’ai écrites. Quelle vitesse doit avoir la première boule pour qu’après la collision, elle soit immédiatement immobile ? Personnellement, c’est une question que je m’étais toujours posée en observant ce type de choc. Avec ces formules, vous pouvez trouver les conditions pour lesquelles cela survient ! Et la réponse vous surprendra peut-être. Vous pouvez aussi chercher les conditions pour obtenir des vitesses opposées, etc.

Une définition de l’énergie.

L’unité seule ne suffit pas à reconnaître une quantité comme étant une énergie : si je divisais une masse par un temps, obtiendrais-je une « vitesse de masse » ? Non, j’obtiendrais une quantité dont l’unité est le kg.s-1, mais qui n’a pas forcément de sens. Il ne suffit pas de mélanger des quantités donnant des joules, pour obtenir une énergie. Il faut trouver, dans les équations qui régissent le système, la quantité invariante au cours du temps qui correspond.

Je complète donc la définition que j’ai proposée :

L’énergie est une grandeur physique dont l’unité est le joule (J). Quelle que soit la nature du système physique à l’étude, il est toujours possible d’en dégager une expression mathématique homogène à une énergie. Pour un système isolé, cette grandeur se conserve au cours du temps.

De ce qui est magique et de ce qui ne l’est pas

J’écris cet article pour partager une vision très personnelle de ma discipline, la physique, pour la mettre en perspective et expliquer en partie pourquoi elle me fascine. Et pour cela, je vais parler de magie.

De magie ?

Oui, de magie. Et je ne parle pas de prestidigitation, je parle de la « vraie » Magie, celle des super-héros, des mages, bref, de tout ce qui peut exister dans un livre fantastique. Que se passerait-il si, par exemple, des capacités de télékinésie apparaissaient chez certains individus ? En fait, avant ça, on pourrait déjà s’intéresser à un personnage présentant cette faculté, dans un film ou un roman.

Pensez à Luke Skywalker sur la planète Dagobah, en compagnie de Yoda, en plein entraînement pour maîtriser la Force ! Rappelez-vous, quand il parvient à faire léviter les pierres tout en faisant le poirier. Vous souvenez-vous, peu après, qu’il échoue à extraire grâce à la Force son vaisseau qui sombre dans les marécages ? Cela ne choquera personne : Luke n’est pas assez entraîné pour faire léviter d’aussi gros objets, voilà tout. C’est normal.

C’est normal ? Pourquoi ce serait normal ? Pourquoi cela vous paraîtrait normal ? Nous parlons de Magie, de quelque chose qui échappe aux lois physiques. Pourtant, au-delà de rendre l’action intéressante – si le personnage est d’emblée tout puissant, ce serait assez ennuyeux –, cela paraît naturel. Un effet plus important demande des efforts plus importants de la part du personnage qui utilise sa magie. Autrement dit, vous n’accepteriez pas que le personnage puisse faire comme bon lui semblerait, vous lui imposez une loi. Vous contraignez la Magie à obéir à un principe, que vous ne connaissez pas en détail, mais qui est présent. Mais je vous vois venir ! Et si, par esprit de contradiction, vous accepteriez au contraire que le personnage puisse déplacer une pierre, un immeuble ou une planète sans que cela ne lui coûte d’effort supplémentaire ? Hé bien vous imposeriez aussi une loi à sa Magie ! En fait, vous êtes cernés. Quoi que vous pensiez, vous formulerez une loi implicite à laquelle la Magie ne peut échapper. Un pouvoir donnant un résultat aléatoire est encore un principe, pas une absence de principe !

Tout ça pour dire quoi ? Tout ça pour dire que, même pour quelque chose d’aussi « exotique » que la Magie, celle-ci ne serait pas dénuée d’une structure. En effet, si le concept même de Magie ne reposait sur aucune structure, nous ne pourrions même pas l’imaginer, donc nous parlerions d’autre chose que de Magie ! Conséquence : nous ne serions pas si désemparés que ça devant les phénomènes magiques, et ils n’auraient pas un caractère impénétrable.

Imaginons que demain, un pouvoir de télékinésie se manifeste parmi la population. Qu’est-ce qui empêcherait des curieux de mesurer la capacité télékinésique maximale d’une personne en lui faisant soulever des objets de plus en plus lourds par la pensée ? À supposer que cela demanderait de plus en plus d’efforts au pratiquant, on pourrait ainsi attribuer un niveau de « force mentale » à chacun, notion floue mais quantitative. Puis, on pourrait peut-être déceler des points communs chez les personnes les plus douées. Peut-être que leur caractère partagerait telle ou telle similitude, ou leur ADN, ou leur électroencéphalogramme, ou peut-être pas ! Mais la réponse à nombre de questions pourrait être éprouvée, et par conséquent, nous assisterions aux balbutiements d’une nouvelle science ! Parce qu’elle serait toute nouvelle, il lui faudrait manipuler dans un premier temps des notions pas forcément bien définies, mais à mesure que les scientifiques de la Magique gagneraient en compréhension, ces notions se verraient reprécisées, reformulées de manière à chasser toute ambiguïté. En mécanique par exemple, les notions de force, de vitesse ou d’inertie étaient plutôt confuses avant l’arrivée de Newton.

Arrivée à un certain stade de développement, un lien entre la Magique et la Physique pourrait être découvert, réunifiant les deux sciences, ou au contraire, démontrant qu’elles ne peuvent pas se combiner, auquel cas elles resteraient deux sciences parallèles aux domaines bien délimités.

Ça, c’était pour aller de la Magie aux Sciences. Pour moi, il n’y a pas de doute que l’apparition de phénomènes magiques (qui a dit que les scientifiques étaient désespérément terre-à-terre ? Détrompez-vous, c’est tout l’inverse !) ne fournirait rien d’autre qu’un tout nouveau terrain d’exploration pour l’investigation scientifique.

Maintenant, allons de la Physique à la Magie.

Le pourquoi ou le comment ?

La physique ne répond jamais à la question du pourquoi, mais cherche toujours à répondre à la question du comment. La raison en est qu’elle permet d’étudier et d’établir des liens entre diverses notions définies, mais pas l’origine de ces définitions. Il est toujours nécessaire de se baser sur des postulats qui ne peuvent pas être démontrés. S’ils le sont, cela ne peut être qu’à partir de postulats encore plus fondamentaux.

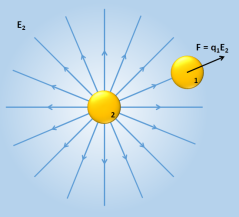

Quand deux particules chargées sont mises côte à côte, elles s’attirent ou se repoussent selon qu’elles sont de signes opposés ou identiques. Chaque particule exerce donc une force sur sa voisine. Mais comment est-ce possible ? Comment une particule peut-elle savoir qu’une autre se trouve à proximité d’elle et qu’elle « doive » subir effectivement cette force ? La Magie n’est pas encore tout-à-fait là. Par facilité, on pourrait considérer que la matière est consciente et le problème se résout de lui-même. Ou alors, on peut envisager qu’une charge électrique seule crée quelque chose autour d’elle, dans l’espace environnant, et qu’en plaçant une autre charge dans ce quelque chose, cette dernière subisse une force. Ce quelque chose, baptisons-le champ électrique.

La force électromagnétique qui s’exerce sur la particule 1 du fait de la présence de l’autre s’écrit

,

avec une constante,

et

les charges de chaque particule et

la distance entre elles.

On remarque que cette formule ne nous interdit pas de rassembler d’un côté des termes ne dépendant que de la particule 2, et de ne laisser de l’autre que la charge électrique de la particule 1. On peut ainsi faire apparaître une quantité que l’on appelle le champ électrique , ici créé par la particule 2 :

.

Écrire la force ainsi ne démontre pas la réalité physique du champ électrique. Ça n’est pour l’instant qu’un artifice de calcul. Néanmoins, les mathématiques n’interdisent pas cette formulation, ce qui est déjà quelque chose !

Ce qui démontre la réalité du champ électrique (et du champ magnétique par la même occasion), c’est l’existence de la lumière. À partir d’une charge électrique que je mets en mouvement à vitesse constante, je peux générer un champ magnétique. Si j’accélère cette charge électrique, c’est-à-dire si je change cette vitesse, les champs électrique et magnétique varient ensemble, et il se produit quelque chose de remarquable : la variation de chacun des champs génère l’autre ! Autrement dit, le champ électrique qui évolue donne naissance, lui-même, à un champ magnétique qui évolue aussi, et celui-ci recrée à son tour un champ électrique. L’ensemble des deux champs, le champ électromagnétique, devient totalement autonome ! Il est sa propre source et n’a plus besoin de charges pour exister. Cette configuration particulière de champ est ce qu’on appelle la lumière (et je pense que vous ne remettrez pas en cause son existence).

Mais au final, qu’est-ce qu’une charge et un champ électriques ? Pourquoi ont-elles cette nature profonde ? Pourquoi ces entités physiques se manifestent ainsi ? Impossible pour la Science de répondre à ces questions, ces « pourquoi » relèvent de la métaphysique et non de la physique. Remplacez « pourquoi » par « comment » et la physique le pourra à nouveau, reliant les propriétés de ces entités à des entités plus fondamentales encore. Mais les questions demeurent. Et bien que, personnellement, je n’aie pas besoin de réponses à ces questions, qui enroberaient les choses d’un voile de mysticisme que je juge inutile, en revanche, j’estime que ces entités physiques elles-mêmes (et en toute généralité) ont quelque chose de réellement magique.

« Électrique » est un mot que vous jugerez probablement d’une banalité affligeante, mais si vous me demandiez de le remplacer par « télékinésique », je ne dirais pas non. En fait si, je dirais non, ça ne serait pas pratique de faire toutes ces substitutions pour si peu ! Mais dans le fond, ça ne me dérangerait pas. Parce que cette charge est réellement capable d’influer à distance sur une autre, en créant autour d’elle un champ. Et même si cette action ne provient pas d’un esprit humain, ne peut-on pas la qualifier de télékinésique ? L’Histoire nous dit que Thalès de Milet a découvert les effets d’attraction dus à l’électricité statique grâce à l’ambre jaune, appelée « êlektron » en grec. Soit ! « Électrique » renseigne donc sur l’origine de la première découverte de cette catégorie de phénomènes, rien de plus. Il souffre malheureusement, comme tant d’autres, de la banalisation due à son usage massif à notre époque. Mais il ne doit pas faire oublier la Magie simplement présente dans le concept qu’il désigne !

Bien entendu, charges et champs électriques ne sont pas le seul exemple qui s’inscrivent dans cette démarche, à mon sens. Très proches de cet exemple, il y a les champs magnétiques (mais pas de charges magnétiques) qui autorisent ce type d’action à distance entre des aimants. Il y a les masses (les charges gravitationnelles, qui ne peuvent que s’attirer) et les champs gravitationnels. Il y a finalement n’importe quel concept de physique, à partir du moment où on a réussi à le débarrasser de sa banalité qui nous vient du quotidien, et à le repenser pour lui-même. Un enfant peut s’émerveiller d’un peu d’eau qui coule, cela n’a rien de banal pour lui qui le découvre pour la première fois. Pourtant, nous pouvons tout autant trouver ça captivant, par exemple en songeant au fait que cette simple chute est provoquée – à distance – par l’action d’une planète entière de 6 millions de milliards de milliards de tonnes.

Et enfin, il y a, plus forcément des concepts, mais aussi des réalisations scientifiques qui démontrent toujours un peu plus le champ des possibles sous ces lois physiques qui semblent si contraignantes. On peut trouver pêle-mêle des fluides qui ne sont ni des liquides, ni des gaz, des matériaux parfaitement conducteurs alors que leur structure est parsemée de défauts, des objets qui sont à la fois dans un état et dans un autre, des liquides qui peuvent indéfiniment s’échapper de leur récipient en grimpant sans efforts sur leurs parois, des particules qui franchissent des murs infranchissables, du vide rempli de particules et d’énergie…

Et ça n’est pas parce qu’on peut comprendre comment c’est possible que ça n’est pas magique !

Couleurs primaires et synthèses des couleurs

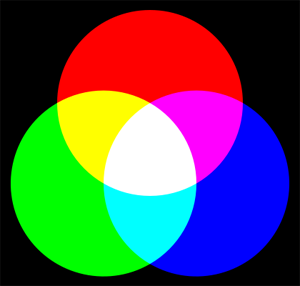

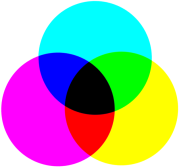

J’ai toujours été fasciné par le nombre de couleurs primaires. Trois. Trois couleurs à mélanger et on obtient du blanc, comme sur le diagramme que tout le monde connaît (ci-dessus). Pourquoi trois ? Je ne comprenais pas très bien. D’un côté, je savais que c’était vrai puisque chaque pixel qui compose un écran est un ensemble de trois sources rouge, verte et bleue.

Mais de l’autre, l’expérience du prisme de Newton, que tout le monde connaît aussi, me disait que la lumière blanche était constituée de toutes les couleurs du spectre visible à la fois. Et je n’avais pas de raison de douter non plus puisque chaque arc-en-ciel était là pour répéter naturellement l’expérience. Du coup, pourquoi le diagramme n’était pas incomplet ? Pourquoi juste trois couleurs et pourquoi celles-là ? Et puis parfois le jaune, le cyan et le magenta débarquaient dans l’histoire et la confusion ne faisait que s’accroître.

Questions préliminaires.

Pour comprendre, il faut au moins répondre aux questions suivantes :

– Qu’est-ce que la lumière ?

– Qu’est-ce que la couleur ?

– Comment perçoit-on les couleurs ?

La lumière est un concept qui peut vous paraître étrange. Elle est parfois décrite comme étant une « onde électromagnétique », parfois comme un flux de particules appelées « photons ». Ces deux visions sont a priori antagonistes, incompatibles. Et pourtant, la lumière présente les caractéristiques de l’un et de l’autre selon les situations. Elle est un peu des deux. Je ne détaillerai pas plus ce qu’est la lumière dans cet article, je le ferai probablement à l’occasion d’un autre. Retenez simplement que c’est l’aspect « photon » qui nous intéressera ici pour les phénomènes mis en jeu.

Malgré tout, je ne peux pas éluder l’aspect « onde » trop vite, car vous savez probablement que la lumière visible correspond aux longueurs d’onde comprises entre 380 et 780 nm. La longueur d’onde est une quantité caractéristique d’une… onde. Si vous imaginez une onde se propageant à la surface de l’eau, la longueur d’onde est la distance minimale au bout de laquelle on retrouve l’onde identique à elle-même, typiquement la distance entre deux bosses ou deux creux successifs. Vous pouvez aussi vous focaliser sur un point fixe et mesurer en combien de temps une bosse est remplacée par la bosse suivante : vous aurez mesuré la période (temporelle) de l’onde.

Le lien qui unit le caractère « photon » et le caractère « onde » que possède la lumière se retrouve dans ces quantités. Ainsi, il y a une correspondance directe entre la période temporelle de l’onde et l’énergie qu’un photon transporte. Résultat : il est interdit à une onde de changer de période au cours de sa propagation, même si elle passe dans un autre milieu matériel (de l’air à l’eau par exemple). Cela signifierait en effet que l’énergie du photon correspondant change au cours du temps, et cela enfreint le principe de conservation de l’énergie. En revanche, la longueur d’onde est libre d’être modifiée lorsque l’onde passe dans un autre milieu.

Qu’est-ce que la couleur ? À ce stade, rien. La couleur n’a aucune existence physique, elle ne se rattache à rien dans ce qu’est une onde électromagnétique. La couleur est une perception, quelque chose qui émane de l’interprétation par le cerveau de stimuli extérieurs, mais j’y reviendrai.

Je peux donc identifier deux raccourcis résumés sur le spectre ci-contre. Le premier est de montrer que la lumière est colorée, alors que ça n’est pas une propriété physique de la lumière. Le second est de caractériser la lumière par sa longueur d’onde, alors que la longueur d’onde dépend du milieu de propagation. Pour autant, ces raccourcis sont raisonnables. Mon seul but ici est de dire qu’il vaut mieux oublier momentanément ce type de représentation pour bien comprendre la physique à l’œuvre. Ce qu’il faut retenir, c’est que les différentes composantes de la lumière ne se distinguent donc que par une chose : leur période (si l’on raisonne en terme d’onde) ou leur énergie (si l’on raisonne en terme de photon, ce que l’on privilégiera).

Maintenant, il faut se demander comment fonctionne notre détecteur de lumière, l’œil.

Le processus de détection de lumière, par l’œil.

Je ne détaillerai pas le fonctionnement complet de l’œil ici, seulement sa partie détection, la rétine. La rétine est une membrane qui tapisse le fond de l’œil et qui contient plusieurs types de cellules, les bâtonnets et les cônes. Les bâtonnets comme les cônes sont sensibles à la lumière. Les premiers sont plus nombreux et plus sensibles mais n’entrent pas dans le processus de perception des couleurs, contrairement aux cônes. C’est d’ailleurs pour cette raison que nous voyons en noir et blanc lorsque la luminosité ambiante est très très faible, les cônes n’étant plus stimulés. C’est la vision scotopique.

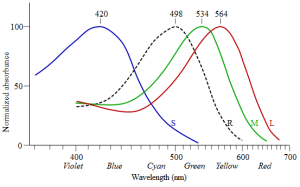

Les cônes sont eux-mêmes subdivisés en trois catégories (Ahaaa ! le nombre trois). À chaque type de cône correspond une molécule photosensible différente (une iodopsine), dont l’efficacité d’absorption en fonction de la longueur d’onde est montrée sur le graphique ci-contre. Ce type de spectre est systématiquement donné en fonction de la longueur d’onde, mais il y est sous-entendu que celle-ci correspond à la longueur d’onde dans le vide. Le milieu de propagation étant fixé, l’ambiguïté sur la longueur d’onde est levée : une correspondance directe longueur d’onde – énergie du photon existe alors. Elle est inversement proportionnelle : une lumière de faible longueur d’onde est un flux de photons plus énergétiques.

Les cônes sont eux-mêmes subdivisés en trois catégories (Ahaaa ! le nombre trois). À chaque type de cône correspond une molécule photosensible différente (une iodopsine), dont l’efficacité d’absorption en fonction de la longueur d’onde est montrée sur le graphique ci-contre. Ce type de spectre est systématiquement donné en fonction de la longueur d’onde, mais il y est sous-entendu que celle-ci correspond à la longueur d’onde dans le vide. Le milieu de propagation étant fixé, l’ambiguïté sur la longueur d’onde est levée : une correspondance directe longueur d’onde – énergie du photon existe alors. Elle est inversement proportionnelle : une lumière de faible longueur d’onde est un flux de photons plus énergétiques.

Bref, si l’on revient au graphique lui-même, les courbes de couleur correspondent aux trois types d’iodopsine et la courbe en pointillés correspond à la rhodopsine qui se trouve dans les bâtonnets.

Chaque fois qu’un photon d’une énergie donnée passe à proximité d’une de ces molécules, celle-ci a une chance plus ou moins grande (donnée par le graphique) d’être modifiée et de finir par déclencher un signal électrique. Ce signal électrique emprunte ensuite le nerf optique et est traité par le cerveau.

Que nous dit ce graphique ?

– Le spectre d’absorption de chaque molécule est très étendu. On ne peut pas réellement dire que chaque type de cône est cantonné à une gamme restreinte d’énergie du photon.

– Les spectres des différentes molécules se recouvrent fortement. Lorsque l’on reçoit de la lumière, excepté si celle-ci correspond aux limites du spectre visible (violet ou rouge), il y a toujours au moins deux types de cônes qui y réagissent.

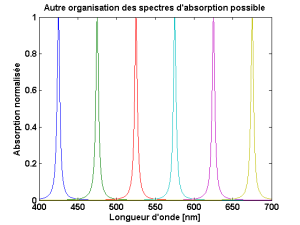

Il y a là quelque chose de doublement contre-intuitif. Ne discriminerait-on pas mieux les énergies des différents photons en ayant d’une part, des cônes très sélectifs en énergie et d’autre part, des spectres d’absorption bien séparés les uns des autres ? (voir spectre ci-contre pour 6 molécules hypothétiques distinctes. Les couleurs ne sont là que pour les différencier.)

La réponse peut être oui, mais pour cela il y a un prix à payer : il faut multiplier les types de molécules photosensibles. Le calcul est on ne peut plus simple. Pour couvrir tout le spectre avec des molécules dont la sensibilité s’étale sur 3 nanomètres, il faut déjà 100 types de molécules différents ! Et vous verriez le monde en 100 couleurs [1]. Pour atteindre notre capacité à distinguer des millions de nuances distinctes, il faudrait des millions de molécules correspondantes avec cette nouvelle organisation. Cependant, si nous étions dans ce cas, notre vision serait si mauvaise qu’elle nous serait probablement inutile. Car pour chaque nuance de couleur, l’œil ne pourrait posséder qu’une poignée de molécules spécialisées réparties sur toute la rétine. Notre œil serait saturé en permanence par la lumière reçue et nous serions sans cesse aveuglés.

La Nature a donc choisi l’alternative déjà décrite, à savoir l’utilisation de trois (et seulement trois) types de molécules photosensibles, qui couvrent chacun une large gamme d’énergie, avec des gammes qui se chevauchent.

Traitement de l’information par le cerveau.

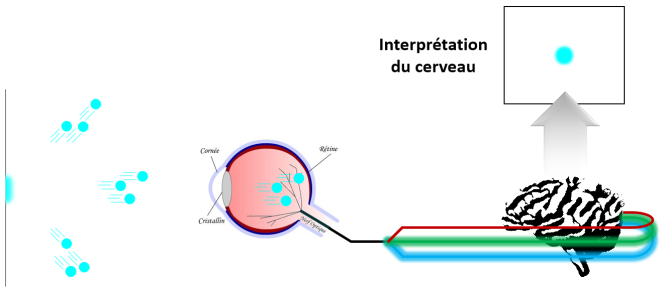

Pour résumer la chaîne de cause à effet que nous examinons ici, il y a :

– Une source de lumière : Elle émet des photons qui se propagent dans l’espace environnant. Chaque photon a sa propre direction.

– Notre œil : Il se trouve sur le chemin de certains de ces photons. Ils pénètrent donc dans l’œil et arrivent sur la rétine. En fonction de l’énergie contenue dans ces photons, ceux-ci ont plus ou moins de chances d’être absorbés par les molécules photosensibles présents dans la rétine. Une fois cette énergie absorbée, la molécule concernée voit son état modifié, ce qui aboutit à l’émission d’un signal électrique.

– Notre cerveau : Il reçoit ces signaux électriques et les traite.

Il est donc important de noter que les seules sources d’information du cerveau sont les signaux électriques provenant de l’œil. Ceux-ci sont différenciés. Le cerveau est informé, en chaque point du champ de vision, des niveaux de signal des trois canaux. C’est à partir d’eux que le cerveau interprète une couleur, une perception sensorielle qui traduit l’énergie du flux de photons détecté en amont. Le cerveau compare l’intensité des trois canaux et associe une couleur à chaque mélange possible. Voilà d’où émanent les couleurs que nous percevons !

Le schéma ci-dessus reprend la chaîne d’évènements décrite. Je rappelle qu’à l’exception de la partie « interprétation du cerveau », aucune des couleurs présentes sur ce schéma n’a d’existence physique : les photons ne sont pas cyan, ils possèdent juste une certaine énergie. Cette énergie stimule deux des iodopsines en une certaine proportion, ce qui déclenche deux signaux électriques dont l’intensité conserve ces proportions et qui empruntent deux canaux (que l’on pourrait nommer 1 et 2) du nerf optique. Le cerveau décide qu’à cette proportion de signal entre les canaux 1 et 2 (et 3, qui n’est pas stimulé), il associe la perception de la couleur cyan. La couleur cyan n’existe qu’à ce stade.

Une fois ce mécanisme éclairci, beaucoup de détails divers sur la vue peuvent être compris.

Conséquence de notre mode de vision des couleurs.

Je me focaliserai ici sur une seule conséquence de notre mécanisme de la vision des couleurs, qui à elle seule débouche sur une série de répercussions intéressantes : l’absence d’équivalence entre énergie des photons et couleur.

On l’a vu, pour éviter d’avoir recours à des millions de molécules photosensibles de type différent, la Nature a rusé en en utilisant que trois aux spectres d’absorption larges et redondants. Mais ce faisant, le cerveau peut être trompé, car l’oeil ne peut pas avoir une connaissance absolue de l’énergie transportée par les photons qu’il reçoit : toute une gamme de photons peuvent exciter la iodopsine correspondant au bleu, par exemple. En croisant les informations provenant des trois iodopsines, le cerveau s’y retrouve mais l’information ne pourra tout de même jamais être complète par ce type de méthode.

À partir de maintenant, je vais moi-même utiliser le raccourci qui consiste à associer la couleur perçue au phénomène physique. Ainsi, un « photon bleu » sera un photon transportant l’énergie correspondant à la couleur bleue. D’une manière analogue, une « iodopsine bleue » sera la iodopsine majoritairement sensible aux photons bleus.

Pour se rendre compte des ambiguïtés dans la perception des couleurs, prenons un flux de photons jaunes par exemple. Si l’on regarde les spectres d’absorption, on remarque que la iodopsine rouge est excitée environ deux fois plus efficacement que la iodopsine verte. Donc, envoyer des photons jaunes déclenche un signal électrique qui code pour 2/3 de rouge et 1/3 de vert. Mais qu’est-ce qui empêche d’envoyer un faisceau de photons rouges et verts de telle sorte à retrouver dans le signal final cette proportion 2/3–1/3 ?